新算法具有卓越的性能表現,可以有效節省高達 70%的大模型推理 RAM 佔用,AI 大模型提供更多的空間,提供強有力的支援。: o' U6 T: y( K3 N

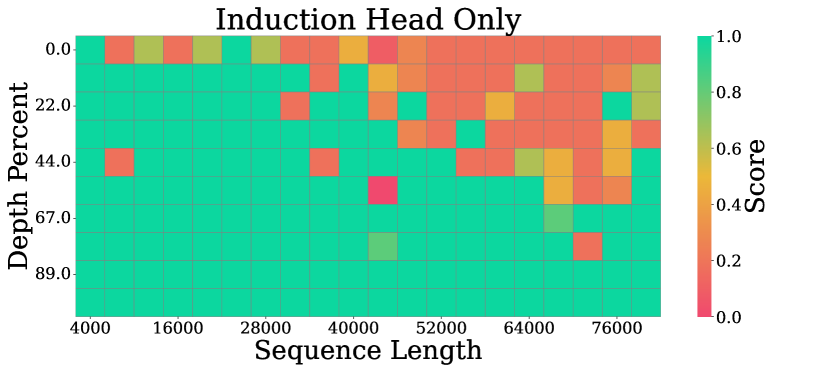

新算法具有卓越的性能表現,可以有效節省高達 70%的大模型推理 RAM 佔用,AI 大模型提供更多的空間,提供強有力的支援。: o' U6 T: y( K3 N 目前相關論文《RazorAttention: Efficient KV Cache Compression Through Retrieval Heads》已被深度學習領域國際頂級會議 ICLR 2025 收錄,可見其重要性。( g7 t1 G1 ~! W3 a' b

目前相關論文《RazorAttention: Efficient KV Cache Compression Through Retrieval Heads》已被深度學習領域國際頂級會議 ICLR 2025 收錄,可見其重要性。( g7 t1 G1 ~! W3 a' b| 歡迎光臨 公仔箱論壇 (http://5.39.217.76/) | Powered by Discuz! 7.0.0 |